Apache Spark là gì? Những ưu điểm nổi bật của apache Spark

BÀI LIÊN QUAN

Ứng dụng hữu ích của Big Data trong ngân hàng hiện nayTìm hiểu những thông tin cơ bản về NoSQL DatabasesBig Data ở Việt Nam phát triển như thế nào?Apache Spark là gì?

Apache Spark là một framework xử lý dữ liệu mã nguồn mở trên một quy mô lớn. Spark cung cấp một giao diện để lập trình các cụm tính toán song song với khả năng chịu lỗi tối ưu. Ban đầu, Spark được phát triển bởi AMPLap của Đại học California Berkeley, sau được được trao lại cho Apache Software Foundation vào năm 2013 và được tiếp tục duy trì phát triển cho đến nay.

Khả năng tính toán phân tán của Spark rất phù hợp với Big data và Machine learning - những hệ thống đòi hỏi công cụ có sức mạnh tính toán khổng lồ. Spark cho phép người dùng xây dựng mô hình dự đoán nhanh chóng nhờ khả năng thực hiện tính toán cùng lúc trên một nhóm các máy tính. Vì thế mà công cụ này giúp loại bỏ một số gánh nặng lập trình cho các nhà phát triển với một API dễ sử dụng.

Spark có thể xử lý dữ liệu theo thời gian thực, tức là có thể vừa nhận dữ liệu từ nhiều nguồn khác nhau, vừa có thể thực hiện xử lý ngay một cách đồng thời. Tốc độ xử lý của Spark nhanh nhờ khả năng tính toán phân tán cùng lúc tại bộ nhớ trong hay hoàn toàn trên RAM.

Spark không có hệ thống phải cho riêng mình. Công cụ này sử dụng nhiều hệ thống file khác nhau như HDFS, S3, Cassandra,... và hoàn toàn không phụ thuộc vào bất cứ hệ thống file nào nói trên.

Những ưu điểm của Apache Spark

Những ưu điểm vô cùng nổi bật của Spark có thể kể đến như:

Tốc độ cao

Được thiết kế với công nghệ hiện đại nhằm tăng hiệu suất, Spark có thể nhanh hơn gấp 100 lần so với apache Hadoop khi xử lý dữ liệu có quy mô lớn bằng cách khai thác tính toán và các tối ưu hóa khác. Bên cạnh đó, apache Spark cũng thực hiện nhanh khi dữ liệu được lưu trữ trên đĩa và hiện đang đứng đầu thế giới về phân loại trên đĩa quy mô lớn.

Sử dụng dễ dàng

Spark có các API thuận tiện cho sử dụng để làm việc trên các tập tin dữ liệu lớn. Với hơn 100 toán tử để chuyển đổi dữ liệu và các API data frame quen thuộc để xử lý các dữ liệu dạng bán cấu trúc.

Thư viện hỗ trợ rộng

Không chỉ có vậy, Spark còn được đóng gói với các thư viện cấp cao, bao gồm hỗ trợ truy vấn SQL, học máy, xử lý đồ thị và truyền dữ liệu trực tuyến. Các thư viện tiêu chuẩn này giúp là tăng năng suất của nhà phát triển và có thể được kết hợp liền mạch với nhau để tạo ra các quy trình làm việc phức tạp.

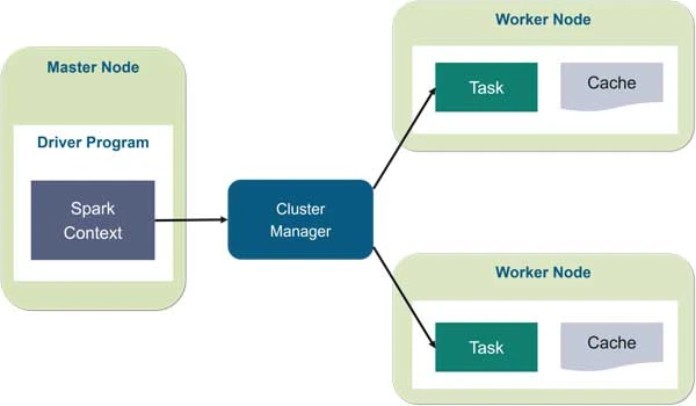

Kiến trúc của Apache Spark

Về cơ bản, Spark gồm có hai thành phần chính là: trình điều khiển (Driver) và trình thực thi (Executors). Trong đó, trình điều khiển có chức năng chuyển đổi mã của người dùng thành nhiều tác vụ có thể được phân phối trên các nút xử lý.

Trình thực thi được chạy trên các nút xử lý và thực hiện các nhiệm vụ đã giao cho chúng. Spark cũng có thể chạy được ở chế độ cụm độc lập chỉ yêu cầu khung Spark và JVM trên mỗi máy tính trong cụm. Tuy nhiên, việc sử dụng các công cụ quản lý cụm như trung gian giữa hai thành phần giúp tận dụng tài nguyên tốt hơn và cho phép phân bổ theo yêu cầu. Trong các doanh nghiệp, Apache Spark có thể chạy trên Docker Swarm, Apache Mesos, Kubernetes.

Spark xây dựng các lệnh xử lý dữ liệu của người sử dụng thành các đồ thị vòng có hướng hoặc DAG. DAG chính là lớp lập lịch của Spark, có chức năng xác định những tác vụ nào được thực thi trên những nút làm việc nào và theo trình tự nào.

Apache Spark có những thành phần nào?

Spark gồm có 5 thành phần chính sau đây:

Spark Core

Spark Core được xem là thành phần nền tảng cốt lõi và tạo điều kiện cho sự vận hành của các thành phần còn lại của Apache Spark. Spark Core có vai trò thực hiện các công việc tính toán, xử lý dữ liệu trong bộ nhớ. Đồng thời, Spark Core còn đảm nhiệm chức năng tham chiếu đến các dữ liệu được lưu trữ tại các hệ thống lưu trữ bên ngoài.

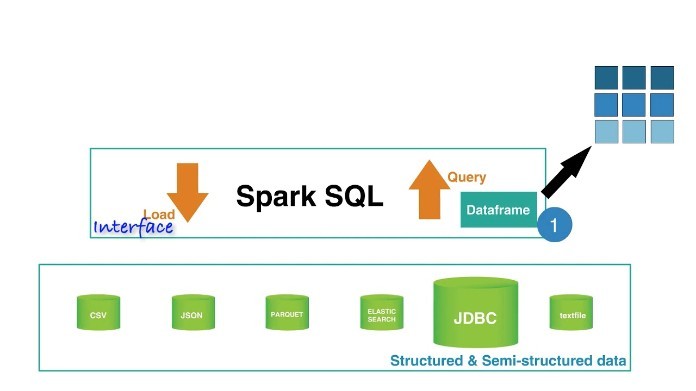

Spark SQL

SQL là thành phần cung cấp Schema DD (một kiểu data abstraction mới) với mục đích hỗ trợ cho các kiểu dữ liệu cấu trúc và dữ liệu nửa cấu trúc. Spark SQL sử dụng phương pháp tiếp cận khung dữ liệu được mượn từ các ngôn ngữ R và Python. Đúng với tên gọi, Spark SQL cũng cung cấp giao diện để truy vấn dữ liệu, mang sức mạnh của Apache Spark đến các nhà phân tích và nhà phát triển doanh nghiệp.

Các giao diện do SQL cung cấp được sử dụng để đọc và ghi vào các kho dữ liệu khác bao gồm HDFS, Apache Hive, Apache ORC, JSON, JDBC và Apache Parquet, tất cả đều được hỗ trợ trực tiếp. Các cơ sở dữ liệu được sử dụng phổ biến khác như MongoDB, Apache Cassandra, Apache Hbase,.. cũng được hỗ trợ thông qua các trình kết nối riêng biệt từ hệ thống sinh thái Spark Packages.

Spark GrapX

GraphX là công cụ đi kèm với các sự lựa chọn thuật toán phân tán để xử lý những cấu trúc đồ thị. Các thuật toán này sử dụng phương pháp tiếp cận RDD của Spark Core để lập thành các mô hình dữ liệu. Gói GraphFrames cho phép người sử dụng thực hiện các xử lý biểu đồ trên khung dữ liệu. Bao gồm cả việc tận dụng trình tối ưu hóa hệ thống Catalyst sử dụng cho các truy vấn đồ thị.

MLlib (Machine Learning Library)

Thành phần tiếp theo trong Spark chính là MLlib - một nền tảng học máy phân tán bên trên Spark với kiến trúc dữ liệu phân tán dựa trên bộ nhớ. Theo một số nghiên cứu của chuyên gia công nghệ và đưa ra kết luận cuối cùng, Spark MLlib có thể chạy nhanh hơn 9 lần so với các thư viện tương đương chạy trên Hadoop là Apache Mahout.

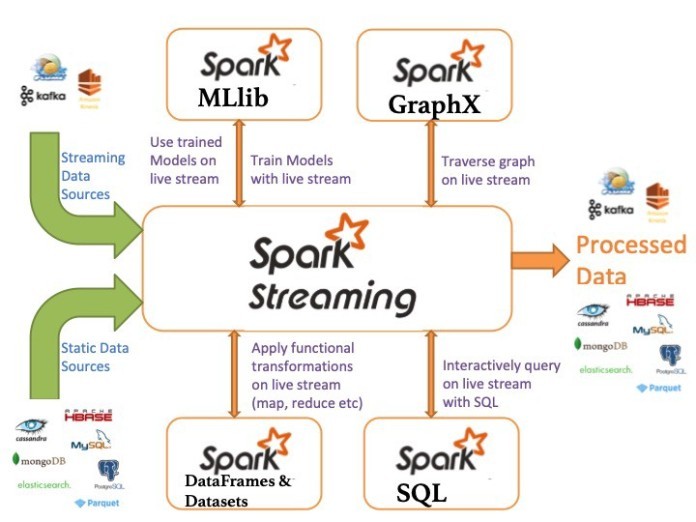

Spark Streaming

Spark Streaming là một công cụ bổ sung ban đầu cho Spark giúp hệ thống này đáp ứng các yêu cầu xử lý thời gian thực hoặc gần như thời gian thực. Spark Streaming hỗ trợ chia nhỏ luồng xử lý thành một chuỗi liên tục gồm các Microbatch mà sau đó có thể được thao tác bằng API Apache Spark.

Mục đích sử dụng của thành phần này chính là coi các stream là các mini batches và thực hiện các kỹ thuật RDD với các dữ liệu này để phân tích. Bằng cách này, mã trong cac xử lý hàng loạt và trực tuyến có thể được tái sử dụng trở lại, chạy trên cùng một framework. Do đó giúp việc phát triển dễ dàng hơn, đồng thời giảm chi phí đầu tư cho cả nhà phát triển và nhà điều hành. Tuy nhiên, trong việc xử lý dữ liệu này có thể sẽ tạo ra độ trễ cho hệ thống.

Lời kết

Trên đây là bài viết giới thiệu đầy đủ và khái quát nhất về công cụ Apache Spark. Qua đó giúp bạn đọc có thể hiểu rõ hơn về định nghĩa, kiến trúc, những thành phần và ưu điểm của hệ thống mang lại khi sử dụng. Tuy là một khái niệm mới nhưng tiềm năng phát triển của Spark trong tương lai là rất lớn, nhất là đối với lĩnh vực IT cùng các công nghệ hiện đại cốt lõi.